Welche Business-Aufgaben lassen sich mit KI-Agenten und generativer KI automatisieren? Erfahren Sie, welche Anwendungsfälle sinnvoll sind, wo Risiken bestehen und wie Unternehmen den echten Mehrwert bewerten können.

Der Diskurs über generative KI ist paradox. Auf der einen Seite gibt es Enthusiasten, deren Geschäftsmodell darauf beruht, den Hype aufrechtzuerhalten. Für sie ist KI bereits die perfekte Lösung für jede Aufgabe.

Auf der anderen Seite stehen die Skeptiker. Viele von ihnen haben einen wissenschaftlichen Hintergrund oder praktische Erfahrung mit Sprachmodellen und wissen, wie oft KI-Systeme in der Vergangenheit überbewertet wurden. Sie haben aus erster Hand erlebt, wie unzuverlässig generative Modelle sein können und sehen, dass die tatsächliche Adoption im Business-Umfeld langsamer ist als erwartet.

In diesem Spannungsfeld ist es für Unternehmen schwierig zu entscheiden, ob eine Investition in generative KI sinnvoll ist.

Bewertung von KI-Anwendungsfällen

Um diese Entscheidung zu erleichtern, bietet sich folgende Faustregel an:

✅ Gute Anwendungsfälle

Die Aufgabe ...

✔ könnte von einem Menschen erledigt werden, ist aber zeitaufwendig oder monoton.

✔ kann leicht überprüft und korrigiert werden.

✔ hat eine gewisse Fehlertoleranz.

Ein Beispiel dafür sind Code-Assistenten. Sie eignen sich für Aufgaben, die Entwickler mit gewissem Aufwand und überschaubarer Recherche selbst lösen könnten. Die generierte Lösung lässt sich schnell auf Plausibilität prüfen, und Fehler sind in der Regel leicht erkennbar und korrigierbar.

⚠️ Schwierige Anwendungsfälle

Die Herausforderung ist größer, wenn das System Antworten generiert, die nicht überprüft werden können, bevor sie an den Endnutzer weitergegeben werden.

Ein Beispiel sind Chatbots. Ihre Fehlertoleranz hängt stark vom Anwendungsfall ab:

✔ Besser geeignet für interne und informative Anwendungen, bei denen Nutzer Fehler leicht erkennen und korrigieren können.

❌ Schwieriger für externe und bindende Interaktionen, wo Fehler direkte geschäftliche oder rechtliche Konsequenzen haben können.

➡ Ein allgemeiner Informations-Chatbot hat mehr Spielraum, solange er höflich, hilfreich und unverbindlich bleibt.

➡ Ein Chatbot, der Beratung oder Verkauf im Namen einer Firma übernimmt, muss hingegen extrem präzise sein.

Fehler lassen sich mit hohem Aufwand minimieren, aber nicht vollständig verhindern. Das macht den Einsatz von generativer KI in geschäftskritischen, externen Anwendungen riskant.

❌ Ungeeignete Anwendungsfälle

Hat ein System keine Fehlertoleranz und können Ergebnisse nicht überprüft werden, ist generative KI ungeeignet oder nur als eingeschränkter Bestandteil eines sonst stark reglementierten Systems nutzbar.

Dazu gehören:

❌ Vollautomatische Generierung sensibler Inhalte

❌ Chatbots mit rechtlich bindenden Antworten

Hier ist die Fehlertoleranz praktisch null – ein einziger falscher Output kann erhebliche Konsequenzen haben.

Was ist Agentic AI?

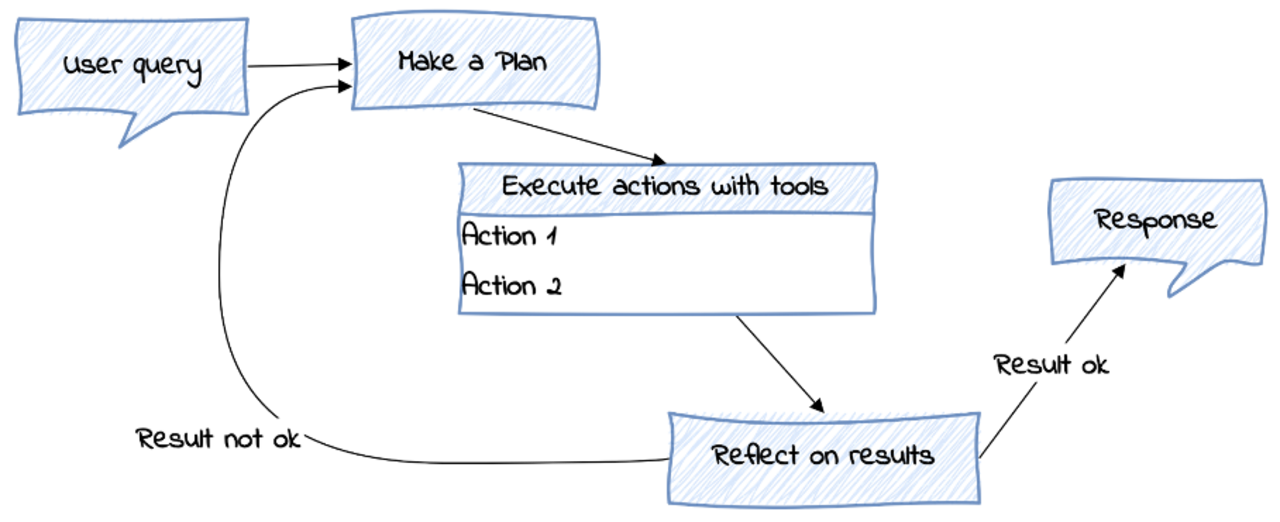

„Agentic AI“ ist ein Begriff, der aktuell für viel Hype sorgt. Er beschreibt Systeme, die mehrschrittige Aufgaben übernehmen – etwa durch iteratives Planen, Schlussfolgern und die Nutzung externer Werkzeuge.

Ein Beispiel: Automatisierte Terminplanung

Stellen Sie sich vor, Ihr KI-System soll eine komplexe, mehrschrittige Aufgabe erledigen – zum Beispiel die Planung eines Meetings mit mehreren Teilnehmern.

Das System mag ein allgemeines Schema für diesen Prozess haben, muss aber an mehreren Stellen eigenständig Schritte planen und ausführen:

1️⃣ Zuerst muss es mit dem Nutzer klären, wer teilnehmen soll, ob das Meeting online oder vor Ort stattfinden soll und welcher Zeitraum bevorzugt wird.

2️⃣ Anschließend greift das System auf die Kalender der Teilnehmer zu, sucht nach gemeinsamen freien Zeitfenstern und schlägt eine passende Option vor.

3️⃣ Danach erstellt es den Termin im Kalender, versendet Einladungen und verarbeitet mögliche Änderungswünsche, indem es den Termin anpasst oder Alternativen vorschlägt.

4️⃣ Während des gesamten Prozesses muss die KI die gesammelten Daten auswerten, Konflikte erkennen und gegebenenfalls Rückfragen an den Nutzer stellen.

Solche Aufgaben erfordern mehr als nur einfache Texterzeugung – sie verbinden dynamische Planung, Kontextverständnis und die Fähigkeit, externe Tools zu nutzen.

Wie verändert Agentic AI den Einsatz generativer KI?

Agentic AI ermöglicht es, komplexere Probleme mit generativer KI anzugehen. Durch iterative Verbesserungsschritte können Fehler erkannt und korrigiert werden, wodurch die Fehlerfrequenz reduziert wird.

Das ist besonders relevant für interaktive und dynamische Prozesse, bei denen generative KI bisher an ihre Grenzen gestoßen ist. Durch die Fähigkeit, Kontext neu zu bewerten, Entscheidungen anzupassen und externe Werkzeuge zu nutzen, lassen sich Systeme entwickeln, die über eine reine Texterzeugung hinausgehen.

Doch das Grundproblem bleibt bestehen:

Sprachmodelle machen ab und zu unvorhersehbare Fehler.

Die Faustregel bleibt daher auch für Agentic AI gültig:

✅ Wenn Fehler korrigierbar sind und eine gewisse Fehlertoleranz besteht, kann KI erheblichen Mehrwert bieten.

❌ Wenn Fehler inakzeptabel sind, bleibt generative KI eine riskante Lösung.

Fazit

Sprachmodelle sind ein Werkzeug, kein Wundermittel. Erfolgreicher Einsatz erfordert realistische Erwartungen und ein gutes Verständnis der eigenen Anforderungen.

Agentic AI erweitert die Einsatzmöglichkeiten von generativer KI, indem es neue Anwendungsfälle erschließt. Aber es beseitigt nicht das Kernproblem der Fehleranfälligkeit – und genau das muss bei der Planung und Umsetzung solcher Systeme berücksichtigt werden.

Headergrafik erstellt mit Sora

Datum: 13.03.2025

Sprechen Sie uns an

Bertram Sändig

Bertram ist Experte für KI- und Machine-Learning-Systeme mit einem Fokus auf NLP und Neural Search. Er hält einen B.Sc. in Informatik der FH Brandenburg und seit 2018 einen M.Sc. der TU Berlin mti den Schwerpunkten Machine Learning und Robotik. Parallel zum Studium war er fünf Jahre Leitender Software-Ingenieur im Space Rover Project des Luft- und Raumfahrtsinstituts der TU-Berlin. 2018 stieg er als Machine Learning Engineer bei Neofonie ein und leitet heute das Machine Learning Team bei ontolux, einer Marke der Neofonie GmbH. Mit großer Leidenschaft überführt er aktuelle Forschungsergebnisse in nutzbare Anwendungen für Kunden, vor allem an der Anpassung, Optimierung und Integration von Large Language Modellen in Suchsysteme und das Textanalyse-Toolkit von ontolux.